如果您Fork本仓库,请先阅读:如何基于Github Issues与Github Actions写技术博客?

AI [1篇]

- 2019-09-22 Keras入门—Hello,World

Apps [1篇]

- 2017-06-29 iOS开发入门

Blog [1篇]

- 2022-11-10 如何基于Github Issues与Github Actions写技术博客?

Databases [6篇]

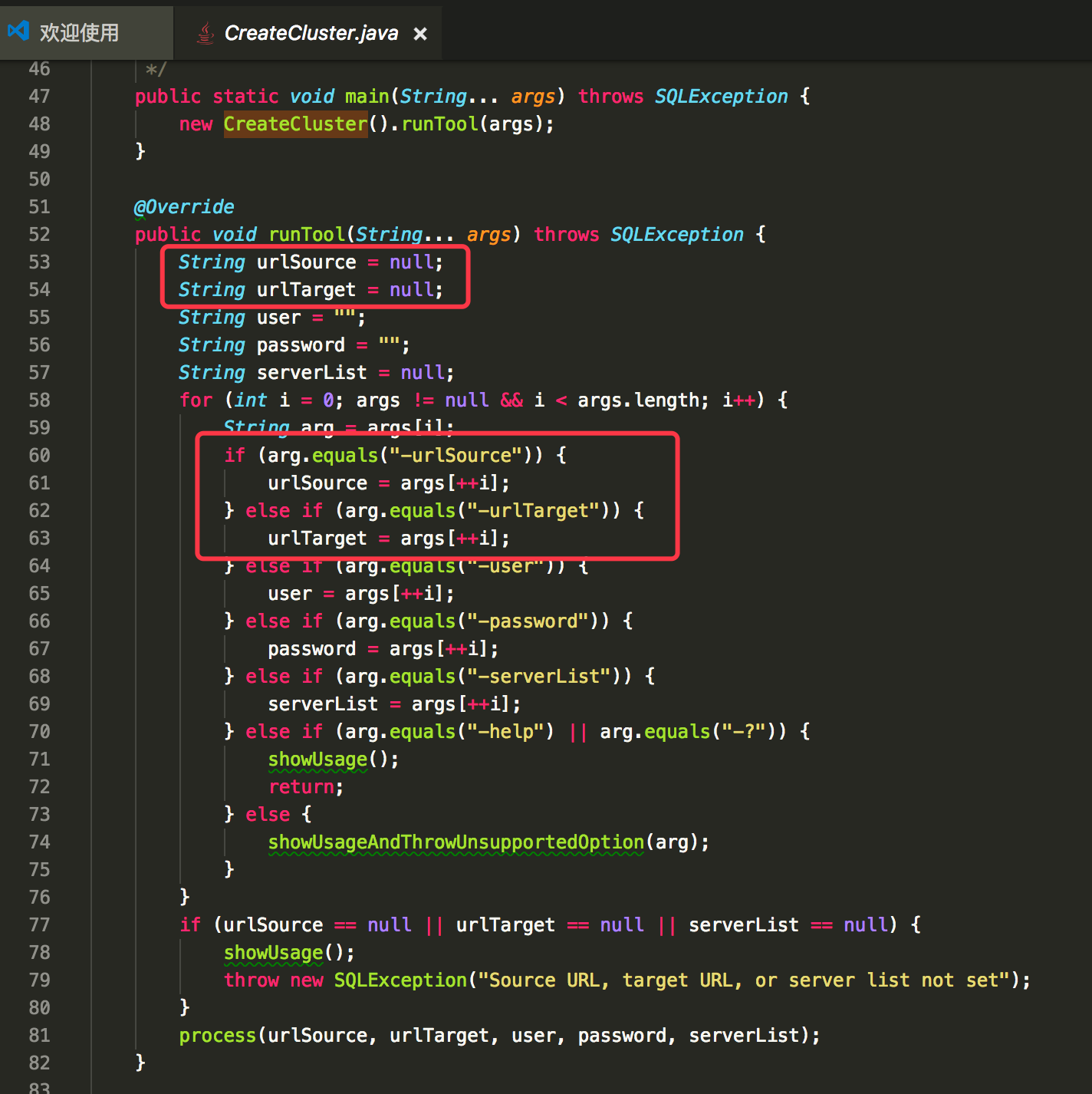

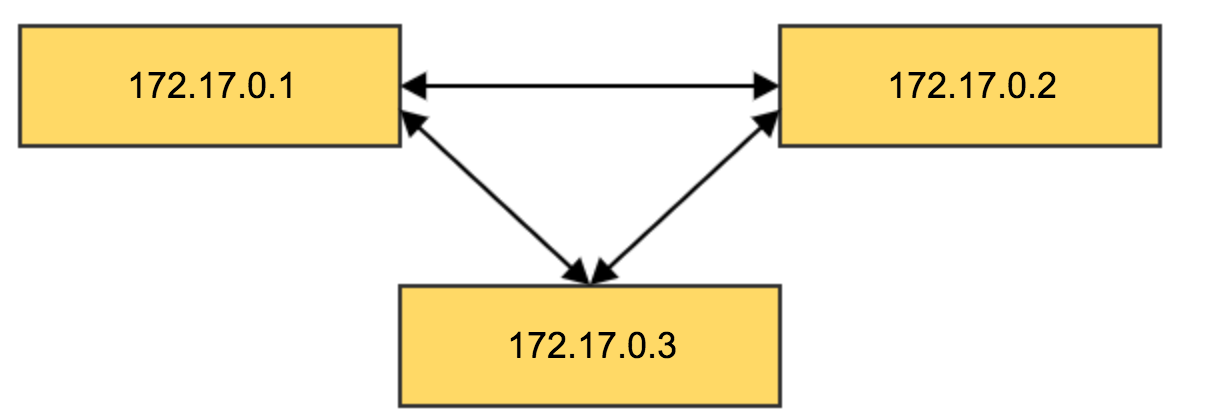

- 2017-08-02 H2数据库集群搭建(主从结构)

- 2017-07-28 H2数据库安装与使用(单点)

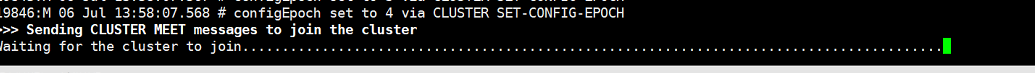

- 2017-06-30 生产环境部署Redis Cluster集群

- 2017-06-30 MongoDB 副本集部署-3.6版本

- 2017-06-29 Oracle 命令行小结

- 2017-06-29 Redis安装、配置及使用(单机版)

Docker [6篇]

- 2020-01-28 Docker容器—CentOS中文乱码/时区混乱问题

- 2017-10-10 Docker容器—HBase安装

- 2017-09-05 Kubernetes—使用Minikube搭建Nginx集群

- 2017-08-23 Kubernetes—简介以及部署方案

- 2017-07-11 Docker固定IP设置

- 2017-07-05 Docker容器启动后自运行脚本的配置

Guitar [1篇]

- 2018-07-07 乐理知识系列之和弦

Java Web [11篇]

- 2019-03-28 Springboot系列之—war包部署&配置文件分离

- 2019-03-28 Springboot系列之—动态配置logback路径

- 2018-04-11 BMP图片详解

- 2018-02-28 SpringBoot系列之—Apache Shiro整合

- 2017-11-18 SpringBoot系列之—日志打印的问题(经验总结)

- 2017-11-12 SpringBoot系列之—瘦身部署

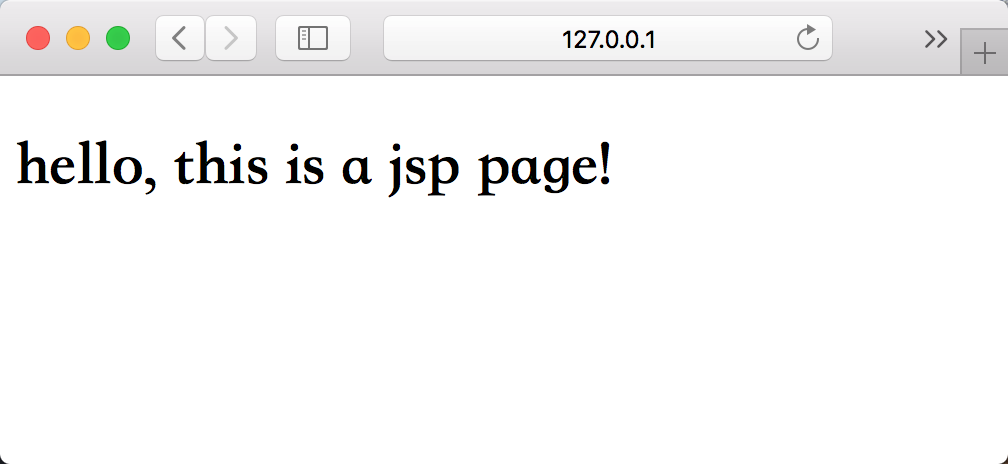

- 2017-11-04 SpringBoot系列之—Web开发实战

- 2017-09-30 Java基础—线程安全与锁

- 2017-09-29 Java基础—NIO基础概念

- 2017-07-03 Gson转换JSON的坑

- 2017-07-03 Tomcat安全加固

keras [1篇]

- 2019-09-22 Keras入门—Hello,World

Linux [13篇]

- 2024-07-13 解决 curl: Protocol "https" not supported or disabled in libcurl

- 2018-11-20 Redhat 6 :This system is not registered to Red Hat Subscription Management

- 2018-11-16 Connector/Python安装—使用Python连接MySQL

- 2018-05-14 CentOS 7 安装JDK

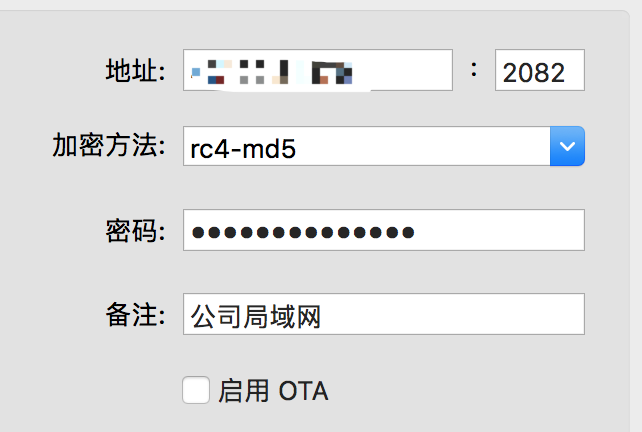

- 2018-02-12 CentOS 7 搭建局域网VPN-Shadowsocks

- 2018-02-09 CentOS 7 更改网卡名

- 2018-01-25 SSH使用问题以及解决方案(expecting SSH2_MSG_KEX_ECDH_REPLY)

- 2018-01-11 autossh内外网穿透方法

- 2017-09-25 Linux Socket Exception

- 2017-09-07 CentOS 安装 Ruby 2.3.0

- 2017-08-10 Supervisor 安装使用

- 2017-07-13 CentOS 6 配置:Keepalived + Nginx

- 2017-07-05 CentOS开机启动脚本

MongoDB [1篇]

- 2017-06-30 MongoDB 副本集部署-3.6版本

MySQL [1篇]

- 2018-11-16 Connector/Python安装—使用Python连接MySQL

Python [4篇]

- 2024-07-12 Python3 Requests依赖报错-ImportError: urllib3 v2.0 only suports Openssl 1.1.1+

- 2019-04-28 Python系列之—Web脚手架(flask+gunicorn+守护进程)

- 2019-04-01 开发工具系列之—pyenv:python版本切换

- 2018-11-16 Connector/Python安装—使用Python连接MySQL

RabbitMQ [1篇]

- 2017-06-29 CentOS6.8 安装 RebbitMQ

Redis [1篇]

- 2017-06-30 生产环境部署Redis Cluster集群

SpringBoot [3篇]

- 2017-11-18 SpringBoot系列之—日志打印的问题(经验总结)

- 2017-11-12 SpringBoot系列之—瘦身部署

- 2017-11-04 SpringBoot系列之—Web开发实战

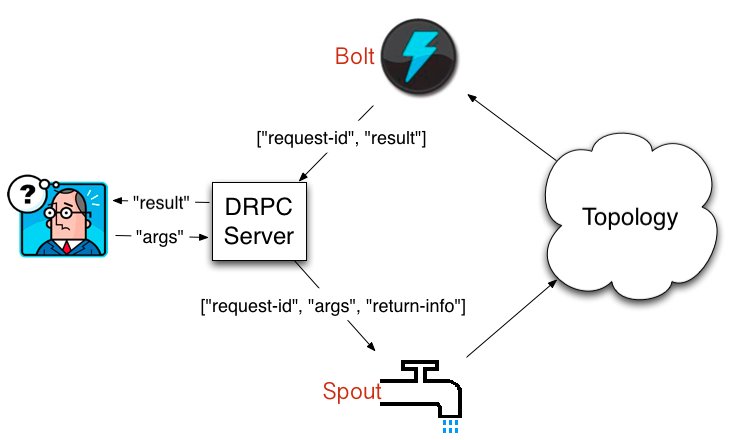

Storm [3篇]

- 2017-07-27 Storm实战—任务部署与调度

- 2017-07-26 Storm实战—安装部署

- 2017-07-25 Storm实战—基本概念

Tools [17篇]

- 2023-02-04 【工具】快速方便下载Youtube的方法

- 2019-07-23 开发工具系列之—GoAcess:Nginx日志分析利器

- 2019-04-01 开发工具系列之—pyenv:python版本切换

- 2019-03-28 开发工具系列之— Macos下homebrew更新慢问题的解决

- 2018-02-27 CentOS 7 安装Gitbook

- 2018-02-12 CentOS 7 搭建局域网VPN-Shadowsocks

- 2018-02-09 日志服务—阿里云日志服务使用记录

- 2018-01-25 SSH使用问题以及解决方案(expecting SSH2_MSG_KEX_ECDH_REPLY)

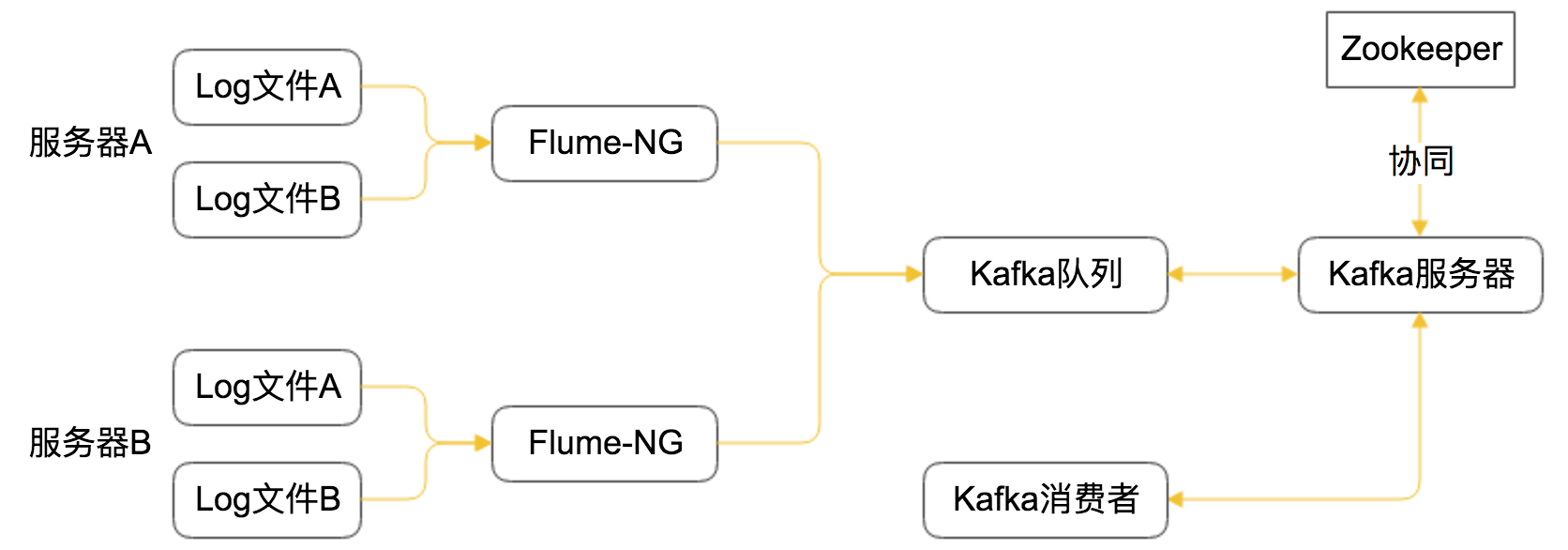

- 2017-09-08 日志服务—使用Flume-NG/Kafaka搭建日志搜集服务

- 2017-09-07 CentOS 安装 Ruby 2.3.0

- 2017-08-22 研发工具清单(持续更新)

- 2017-08-10 Supervisor 安装使用

- 2017-07-31 Zookeeper安装部署(单点/集群)

- 2017-07-13 CentOS 6 配置:Keepalived + Nginx

- 2017-07-03 Tomcat安全加固

- 2017-06-29 Nginx配置多个HTTPS域名

- 2017-06-29 Git 常用命令速查表

区块链 [1篇]

- 2020-10-19 区块链学习—Hyberledger Fabric 网络搭建入门

大数据 [4篇]

- 2017-10-10 Docker容器—HBase安装

- 2017-07-27 Storm实战—任务部署与调度

- 2017-07-26 Storm实战—安装部署

- 2017-07-25 Storm实战—基本概念

机器学习 [1篇]

- 2019-06-04 机器学习算法系列—介绍

读书笔记 [1篇]

- 2017-07-13 《微服务文集 (ThoughtWorks洞见)》